O armazenamento de dados em planilhas do Excel é muito comum e muito importante em diversas situações. Através do componente Excel Input, podemos manipular os dados gravados nestas planilhas, aproveitando inclusive o título das colunas, caso existam.

Observe abaixo as opções do componente:

Aba Files:

Começaremos pela primeira aba, a aba Files.

Nesta aba selecionaremos os arquivos que serão processados. Poderemos escolher um ou mais arquivos diretamente do diretório onde se encontram, ou o nome / caminho do arquivo podem chegar através de um parâmetro ou campo.

Quando os arquivos forem escolhidos, os mesmos aparecerão na coluna File/Directory. Na coluna Wildcard(RegExp), poderemos colocar uma expressão regular que valide os arquivos que queremos importar.

Se desejarmos receber o nome de um arquivo por meio de um campo do fluxo, marcaremos a opção “Accept filenames from previous step”, selecionaremos o step que está ligado ao Excel Input e definiremos o campo que possui o nome/caminho do(s) arquivo(s).

Após determinar os arquivos e pastas, poderemos ver os que fazem parte de nossa seleção através do botão “Show filename(s)...”

Aba Sheets:

Na aba Sheets, definiremos quais planilhas entre os arquivos selecionados usaremos para extrair os registros e inseri-los ao fluxo.

Aba Contents (Conteúdo):

Na aba Content, definiremos outras opções, entre elas:

- Header: se o cabeçalho das colunas será inserido ao fluxo;

- No empty rows: se linhas vazias entrarão no fluxo;

- Stop on empty row: para o processo caso encontre uma linha vazia;

- Limit: limite de linhas que entrará no fluxo;

- Spread sheet type: formato do arquivo que contém a(s) planilha(s), ou seja, xls, xlsx ou ods.

Aba Error Handling:

A aba Error Handling possui algumas opções para o caso de incidência de erros durante o processamento deste step. Através das opções disponíveis, podemos decidir qual ação o fluxo deverá tomar caso haja um erro originado especificamente por este step.

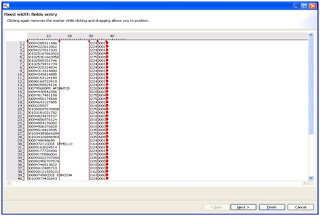

Aba Fields:

Na aba Fields, escolheremos entre os campos das planilhas selecionadas aqueles que entrarão no fluxo. Ao definirmos os campos, poderemos escolher os tipos, tamanho, precisão, formato, etc.

Observe a figura abaixo e perceba que através do botão “Get fields from header row...” podemos adicionar todas as colunas das planilhas automaticamente, sem necessidade de digitá-los um por um.